大量数据,无法一次性读入内存,所以需分批读取,每次处理一小块数据。

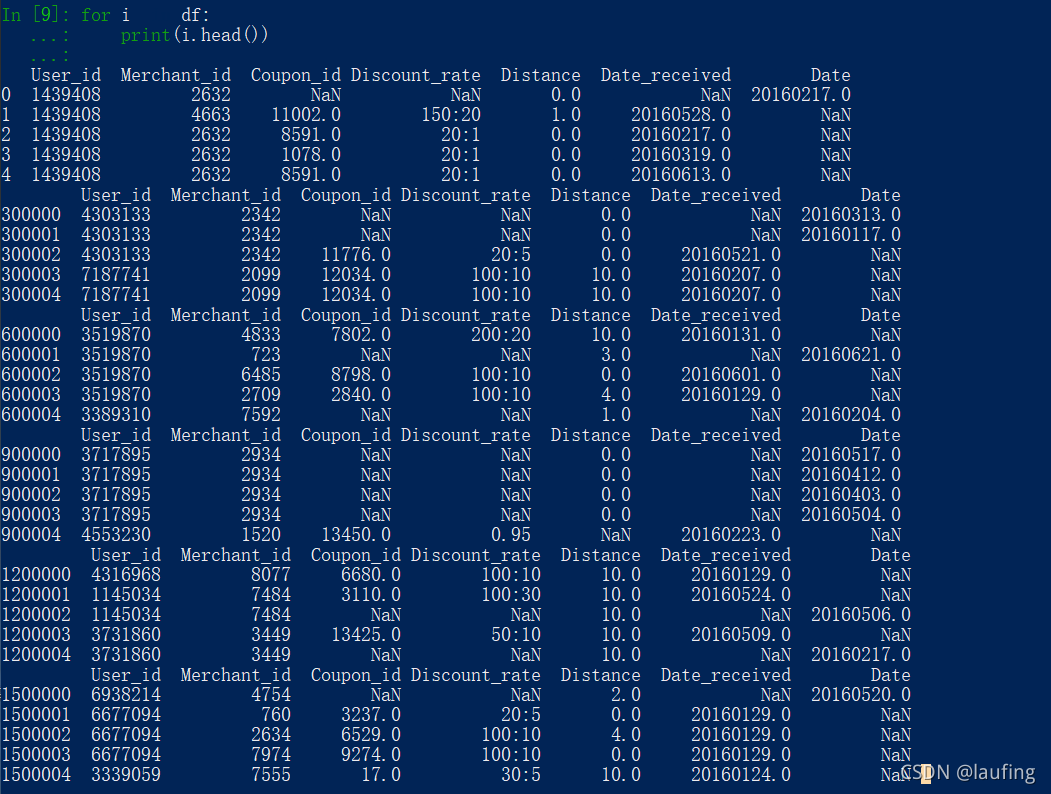

df = pandas.read_csv("xxxx.csv",encoding="utf-8",chunksize=300000) #每块数据 30w 行 for i in df: print(i.head()) 如图:每一块都有header

处理完的每一块数据,追加写入文件中(磁盘)

per_df.to_csv("target.csv",index=False,mode="a",na_rep="null",sep=",",columns=["name","age",],header=False) #index 是否写入行号 #mode 写入的模式 w,替换写入; a,追加写入 #na_rep 缺失值替换为xxx #sep 值之间的分隔符 #columns 需要哪些列,写入文件 #header 是否写入字段名